Date de la publication : 7 janvier 2026

Lecture : 8 min

Faire confiance aux outils agentiques : les leçons à retenir

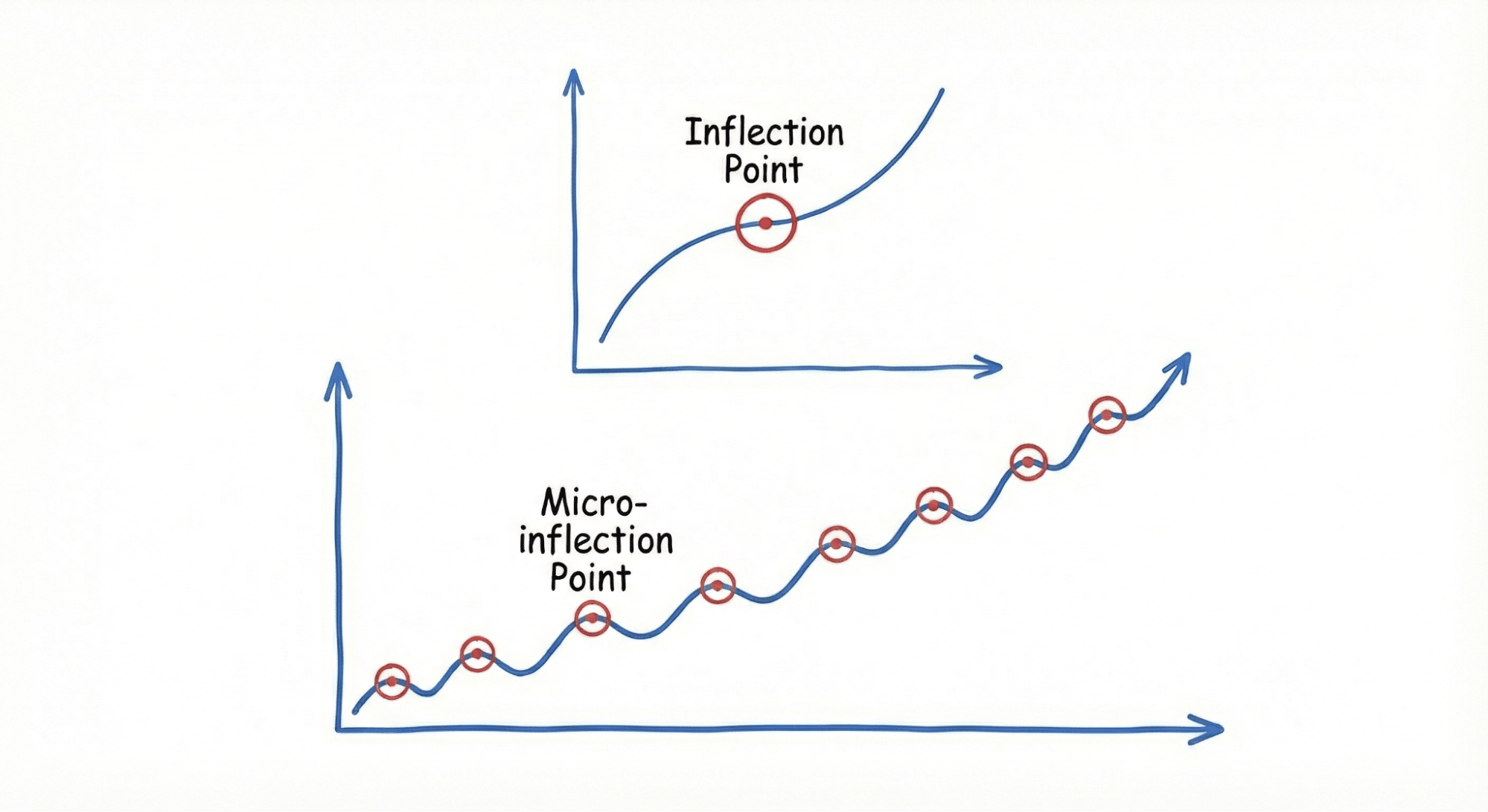

Comment la confiance dans les agents d'IA s'établit à partir de micro-points d'inflexion positifs, et non de grandes découvertes.

À mesure que les agents d'IA deviennent des partenaires de plus en plus sophistiqués dans le développement logiciel, une question critique émerge : comment établir une confiance durable entre les humains et ces systèmes autonomes ? Une récente étude menée par l'équipe UX Research de GitLab révèle que la confiance dans les agents d'IA ne s'établit pas à partir de découvertes spectaculaires, mais plutôt d'innombrables petites interactions, à savoir de points d'inflexion qui s'accumulent au fil du temps pour créer confiance et fiabilité.

Notre étude menée auprès de 13 utilisateurs d'outils agentiques issus d'entreprises de différentes tailles a identifié que l'adoption se produit à travers des « micro-points d'inflexion », des choix de conception subtils et des modèles d'interaction qui établissent progressivement la confiance nécessaire pour que les équipes de développement s'appuient sur les agents d'IA dans leurs workflows quotidiens. Ces résultats offrent des enseignements cruciaux pour les organisations qui mettent en œuvre des agents d'IA dans leurs processus DevSecOps.

Les outils logiciels traditionnels gagnent la confiance des utilisateurs en raison de leur comportement prévisible et de leurs performances constantes. Les agents d'IA, cependant, opèrent avec un degré d'autonomie qui génère une part d'incertitude. Notre étude démontre que les utilisateurs n'adoptent pas des outils d'IA à la suite d'un seul moment décisif. Au contraire, la confiance s'établit à travers des micro-interactions positives accumulées qui prouvent que l'agent comprend leur contexte, respecte leurs garde-fous et améliore plutôt que perturbe leurs workflows.

Ce renforcement progressif de la confiance est particulièrement décisif dans les environnements DevSecOps où les erreurs peuvent impacter les systèmes de production, les données clients et les opérations commerciales. Chaque petite interaction renforce ou érode les fondements de la confiance nécessaire à une collaboration humain-IA productive.

Les quatre piliers de la confiance dans les agents d'IA

Notre étude a identifié quatre catégories clés de micro-points d'inflexion qui renforcent la confiance des utilisateurs :

- Protection des actions

La confiance commence par la sécurité. Les utilisateurs doivent être assurés que les agents d'IA ne causeront pas de dommages irréversibles à leurs systèmes. Voici quelques garde-fous essentiels :

- Dialogues de confirmation pour les modifications critiques : avant d'exécuter des opérations susceptibles d'affecter les systèmes de production ou de supprimer des données, les agents doivent marquer une pause et solliciter une autorisation explicite.

- Capacités de retour à la version précédente : les utilisateurs doivent savoir qu'ils peuvent annuler les actions de l'agent en cas d'erreur.

- Limites sécurisées : pour les organisations soumises à des exigences de conformité, les agents doivent respecter les politiques de résidence et de sécurité des données sans surveillance manuelle constante.

- Transparence des opérations

Les utilisateurs ne peuvent pas accorder leur confiance s'ils ne comprennent pas les opérations. Les agents d'IA efficaces maintiennent une transparence grâce aux éléments suivants :

- Mises à jour en temps réel : particulièrement crucial lorsque l'attention de l'utilisateur pourrait être requise.

- Explications des actions : avant d'exécuter des opérations avec des enjeux élevés, les agents doivent communiquer clairement l'approche qu'ils ont prévue de suivre.

- Gestion claire des erreurs : en cas de problèmes, les utilisateurs ont besoin d'alertes immédiates avec des messages d'erreur compréhensibles et des chemins de récupération.

Grâce à cette transparence, les agents d'IA passent de boîtes noires mystérieuses à partenaires compréhensibles dont les utilisateurs peuvent suivre et vérifier la logique.

- Mémorisation du contexte

Rien n'érode la confiance plus rapidement que de devoir répéter constamment les mêmes informations à un agent d'IA. Les agents qui établissent un climat de confiance possèdent des fonctionnalités de mémoire :

- Rétention des préférences : accepter et appliquer les commentaires des utilisateurs concernant les styles de codage, les modèles de déploiement ou les préférences de workflow.

- Conscience du contexte : se souvenir des instructions précédentes et des exigences spécifiques au projet.

- Apprentissage adaptatif : évoluer en fonction des corrections des utilisateurs sans reprogrammation explicite.

Les participants à notre étude ont constamment souligné leur frustration face à des outils incapables de mémoriser des préférences de base, ce qui les oblige à fournir les mêmes instructions de manière répétée.

- Anticipation des besoins

La confiance s'instaure lorsque les agents d'IA prennent en charge de manière proactive les workflows utilisateurs. Les agents peuvent venir en aide à l'utilisateur de différentes manières :

- Reconnaissance des modèles : apprendre les routines utilisateurs et prédire les tâches en fonction de l'heure de la journée ou du contexte du projet.

- Sélection intelligente d'agents : identifier automatiquement les agents spécialisés les plus pertinents pour des tâches spécifiques.

- Analyse de l'environnement : comprendre les environnements de codage, les dépendances et les structures de projet sans configuration explicite.

Ces capacités d'anticipation transforment les agents d'IA d'outils réactifs en partenaires proactifs qui réduisent la charge cognitive et rationalisent les processus de développement.

La mise en œuvre de fonctionnalités qui instaurent un climat de confiance

Pour les organisations qui déploient des agents d'IA, notre étude suggère plusieurs implémentations pratiques :

- Commencer par des environnements à faible risque : faire en sorte que la confiance s'établisse progressivement en commençant avec des tâches non critiques. À mesure que la confiance s'accroît grâce à des micro-interactions positives, les utilisateurs dépendent naturellement de plus en plus des capacités d'IA.

- Concevoir l'orchestration continue d'agents, avec intervention : contrairement à l'automatisation traditionnelle, les agents d'IA doivent savoir quand s'arrêter et solliciter un humain. Cette intervention assure aux utilisateurs qu'ils maintiennent le contrôle ultime tout en bénéficiant de l'efficacité de l'IA. Les agents ont également besoin de contrôles de niveau d'autonomie afin de calibrer l'autonomie pour différents types d'actions, dans différents contextes.

- Maintenir des pistes d'audit : chaque action d'agent doit pouvoir être tracée afin que les utilisateurs comprennent non seulement ce qui s'est passé, mais aussi pourquoi l'agent a pris certaines décisions.

- Personnaliser l'expérience : les agents qui s'adaptent aux préférences individuelles des utilisateurs et aux workflows d'équipe créent des liens de confiance plus solides que les solutions universelles.

L'impact de la confiance accumulée

Nos résultats révèlent que la confiance dans les agents d'IA suit un modèle de croissance composée. Chaque micro-interaction positive rend les utilisateurs légèrement plus disposés à s'appuyer sur l'agent pour la tâche suivante. Au fil du temps, ces petits signes de confiance s'accumulent pour former une confiance profonde qui transforme les agents d'IA d'outils expérimentaux en partenaires de développement essentiels.

Ce processus est délicat, car un seul échec significatif peut effacer des semaines de confiance accumulée. C'est pourquoi la cohérence dans ces micro-points d'inflexion est cruciale. Chaque interaction compte.

Soutenir ces micro-points d'inflexion est crucial pour que les équipes logicielles et leurs agents d'IA collaborent à l'échelle de l'entreprise avec une orchestration intelligente.

Prochaines étapes

Établir la confiance dans les agents d'IA nécessite une conception intentionnelle axée sur les besoins et préoccupations des utilisateurs.

Les organisations qui mettent en œuvre des outils agentiques devraient :

- Auditer leurs agents d'IA afin de repérer les micro-interactions qui établissent la confiance.

- Prioriser la transparence et le contrôle utilisateur dans la conception des agents.

- Investir dans des capacités de mémoire et d'apprentissage qui réduisent les frustrations des utilisateurs.

- Créer des chemins d'escalade clairs pour lorsque les agents rencontrent de l'incertitude.

Points clés à retenir

- La confiance dans les agents d'IA se construit de manière incrémentale à travers des micro-points d'inflexion plutôt que par des moments de grande découverte.

- Quatre catégories clés favorisent la confiance : la protection des actions, la transparence des opérations, la mémorisation du contexte et l'anticipation des besoins.

- Les petits choix de conception dans les interactions d'IA ont des effets combinés sur l'adoption utilisateur et l'utilisation à long terme.

- Les organisations doivent privilégier de manière intentionnelle la confiance et viser des micro-interactions cohérentes et positives.

Aidez-nous à comprendre ce qui vous tient à cœur : vos expériences et perspectives sont extrêmement utiles pour nous aider à façonner la manière dont nous concevons et améliorons les interactions agentiques. Rejoignez notre panel de recherche pour participer à de futures études.

Découvrez les agents GitLab en action : avec GitLab Duo Agent Platform, la rapidité de l'IA dépasse le simple codage et couvre l'ensemble de votre cycle de vie logiciel. Vos workflows définissent les règles, votre contexte maintient les connaissances organisationnelles et vos garde-fous garantissent le contrôle afin que les équipes puissent orchestrer pendant que les agents exécutent à travers le SDLC. Visitez la page GitLab Duo Agent Platform pour découvrir comment l'orchestration intelligente peut transformer votre parcours DevSecOps.

Que vous testiez des agents pour la première fois ou que vous cherchiez à optimiser vos implémentations existantes, nous sommes convaincus que comprendre et concevoir en visant la confiance est la clé d'une adoption réussie. Construisons cet avenir ensemble !

Votre avis nous intéresse

Cet article de blog vous a plu ou vous avez des questions ou des commentaires ? Partagez vos réflexions en créant un sujet dans le forum de la communauté GitLab.

Donnez votre avis